这家自动驾驶初创公司正在使用生成式人工智能来预测交通

自动驾驶公司 Waabi 今天宣布,正在使用生成式人工智能模型来帮助预测车辆的移动。

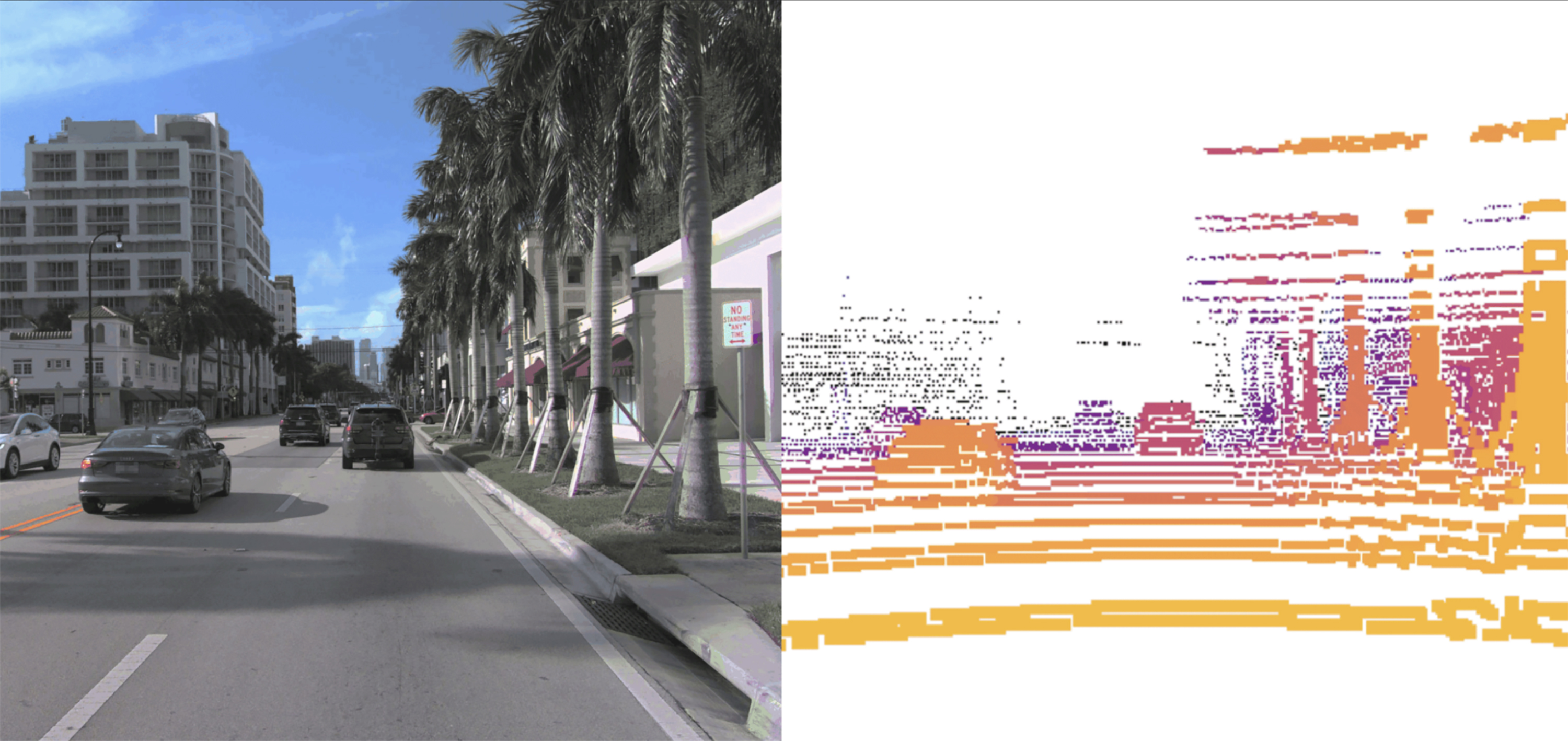

这个名为 Copilot4D 的新系统是根据激光雷达传感器的大量数据进行训练的,激光雷达传感器利用光来感知物体的距离。 如果您向模型提示某种情况,例如驾驶员鲁莽地高速驶入高速公路,它会预测周围车辆将如何移动,然后生成未来 5 到 10 秒的激光雷达表示(可能显示连环相撞) 。 今天发布的消息是关于 Copilot4D 的初始版本,但 Waabi 首席执行官 Raquel Urtasun 表示,Waabi 在德克萨斯州的自动驾驶卡车测试车队中部署了一个更先进、更可解释的版本,可帮助驾驶软件决定如何反应。

虽然自动驾驶长期以来一直依赖机器学习来规划路线和检测物体,但一些公司和研究人员现在押注生成式人工智能——接收周围环境数据并生成预测的模型——将有助于将自动驾驶带入下一阶段。 Waabi 的竞争对手 Wayve 去年发布了一款类似的模型,该模型根据其车辆收集的视频进行训练。

Waabi 模型的工作方式与 OpenAI 的 DALL-E 和 Sora 等图像或视频生成器类似。 它采用激光雷达数据的点云,将汽车周围环境的 3D 地图可视化,并将其分解为块,类似于图像生成器将照片分解为像素的方式。 然后,Copilot4D 根据其训练数据预测激光雷达数据的所有点将如何移动。 连续这样做可以让它生成未来 5-10 秒的预测。

Waabi 是少数几家将自己的方法描述为“人工智能优先 ”的自动驾驶公司之一,其中包括竞争对手 Wayve 和 Ghost 。 对于 Urtasun 来说,这意味着设计一个可以从数据中学习的系统,而不是必须教会如何对特定情况做出反应的系统。 该团队押注他们的方法可能需要更少的自动驾驶汽车道路测试时间,这是 2023 年 10 月 旧金山一辆 Cruise 机器人出租车拖拽行人发生 事故后的热门话题。

Waabi 与竞争对手的不同之处在于为激光雷达而不是相机构建生成模型。

“如果你想成为 4 级玩家,激光雷达是必须的,”Urtasun 说,指的是汽车不需要人类注意力即可安全驾驶的自动化级别。 她说,摄像头可以很好地显示汽车所看到的情况,但它们并不擅长测量距离或了解汽车周围环境的几何形状。

尽管 Waabi 的模型可以生成视频来显示汽车通过激光雷达传感器看到的内容,但这些视频不会用作该公司 用于构建和测试其驾驶模型的 驾驶模拟器的训练。 这是为了确保 Copilot4D 产生的任何幻觉不会在模拟器中被教授。

斯坦福大学博士生伯纳德·亚当·兰格(Bernard Adam Lange)建立并研究了类似的模型,他表示,底层技术并不新鲜,但这是他第一次看到生成式激光雷达模型脱离研究实验室的范围并扩大规模用于商业用途。 他说,这样的模型通常有助于使任何自动驾驶汽车的“大脑”能够更快、更准确地进行推理。

“规模是变革性的,”他说。 “希望这些模型可以用于下游任务”,例如检测物体和预测人或物下一步可能移动的位置。

Copilot4D 只能估计目前为止的未来,并且运动预测模型通常会随着要求向前预测的距离而降低。 Urtasun 表示,尽管 Waabi 强调的基准测试是基于 3 秒的预测,但该模型只需要提前想象 5 到 10 秒发生的情况即可做出大多数驾驶决策。 斯坦福汽车研究中心联席主任 Chris Gerdes 表示,这一指标将是确定模型在决策方面的有用程度的关键。

“如果 5 秒预测可靠,但 10 秒预测几乎无法使用,那么在很多情况下这在道路上是不够的,”他说。

新模型重新提出了一个席卷生成人工智能世界的问题:是否将模型开源。 Copilot4D 的发布将使那些难以获取大型数据集的学术研究人员能够深入了解它的制作过程,独立评估安全性,并有可能推进该领域的发展。 这也会对 Waabi 的竞争对手产生同样的影响。 Waabi 发表了一篇详细 介绍模型创建的 论文,但尚未发布代码,Urtasun 不确定他们是否会发布。

“我们希望学术界对自动驾驶的未来也有发言权,”她说,并补充说开源模型更值得信赖。 “但我们在开发技术时也需要小心一点,以免我们向竞争对手透露一切。”